Exporter vers Fabric Lakehouse à l’aide de Fabric Notebooks

Vue d'ensemble

L’utilisation de Data Factory dans Microsoft Fabric avec Delta Sharing permet une intégration et un traitement transparents des tables Delta partagées dans le cadre de vos flux de travail d’analyse avec Procore Analytics 2.0. Delta Sharing est un protocole ouvert pour le partage sécurisé des données, permettant la collaboration entre les organisations sans dupliquer les données.

Ce guide vous guide tout au long des étapes de configuration et d’utilisation de Data Factory dans Fabric avec Delta Sharing, à l’aide de blocs-notes pour le traitement et l’exportation de données vers un Lakehouse.

Conditions préalables

- Procore Analytics 2.0 SKU

- Identifiants de partage Delta :

- Accès aux informations d’identification Delta Sharing fournies par un fournisseur de données.

- Un fichier de profil de partage (config.share) contenant:

- URL du point de terminaison (URL du serveur de partage Delta).

- Jeton d’accès (jeton du porteur pour un accès sécurisé aux données).

- Créez votre fichier config.yaml avec des informations d’identification spécifiques.

- Environnement Microsoft Fabric :

- Un compte de locataire Microsoft Fabric avec un abonnement actif.

- Un espace de travail compatible avec Fabric.

- Packages et scripts :

- Téléchargez le package fabric-lakehouse. Le répertoire doit comprendre :

- ds_to_lakehouse.py : Code du bloc-notes.

- readme.md : Instructions.

- Téléchargez le package fabric-lakehouse. Le répertoire doit comprendre :

Procédure

Configurer la configuration

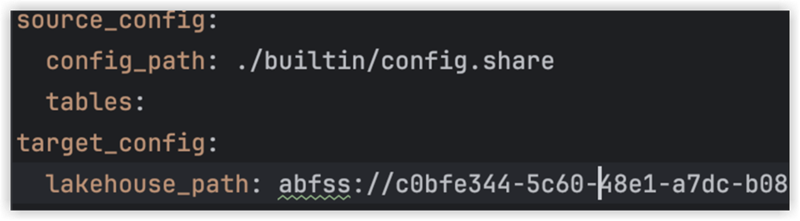

- Créez le fichier config.yaml et définissez la configuration dans la structure suivante

source_config :

config_path : chemin/vers/votre/fichier-d’identifiants-de-partage-delta.share

tables : # Facultatif - Laisser vide pour traiter toutes les tables

- table_name1

- table_name2

target_config :

lakehouse_path : chemin/vers/votre/tissu/lakehouse/tables/ # chemin vers le tissu lakehouse

Configurez votre maison au bord du lac

- Ouvrez votre espace de travail Microsoft Fabric.

- Accédez à votre Lakehouse et cliquez sur Ouvrir le bloc-notes, puis sur Nouveau bloc-notes.

- Si vous ne connaissez pas la valeur dans config.yaml#lakehouse_path, Vous pouvez le copier à partir de l’écran.

- Cliquez sur les points de suspension sur Fichiers et sélectionnez Copier le chemin ABFS:

3. Copiez le code de ds_to_lakehouse.py et collez-le dans la fenêtre du bloc-notes (Pyspark Python) :

L’étape suivante consiste à charger vos propres fichiers config.yaml et config.share dans le dossier Resources de Lakehouse. Vous pouvez créer votre propre répertoire ou utiliser un répertoire intégré (déjà créé pour les ressources par Lakehouse) :

L’exemple ci-dessous montre un répertoire intégré standard pour un fichier config.yaml .

Remarque : assurez-vous de charger les deux fichiers au même niveau et pour la propriété config_path:

4. Vérifiez le code du cahier, lignes 170-175.

L’exemple ci-dessous montre les modifications de ligne nécessaires :

config_path = « ./env/config.yaml »

À

config_path = « ./builtin/config.yaml»

Étant donné que les fichiers se trouvent dans un dossier intégré et non dans un environnement personnalisé, assurez-vous de surveiller votre propre structure des fichiers. Vous pouvez les charger dans différents dossiers, mais dans ce cas, mettez à jour le code du bloc-notes pour rechercher correctement le fichier config.yaml .

5. Cliquez sur Exécuter la cellule :

Validation

- Une fois le travail terminé, vérifiez que les données ont bien été copiées dans votre Lakehouse.

- Vérifiez les tables spécifiées et assurez-vous que les données correspondent aux tables Delta partagées.

- Attendez que le travail soit terminé, il devrait copier toutes les données.